在人工智能领域,大型语言模型(LLM)的应用越来越广泛,但许多用户希望能够在本地环境中部署和运行这些模型,以满足数据隐私、定制化需求或离线使用的场景。 DeepSeek-R1 是最近非常火爆的一个高性能的 AI 推理模型,专注于数学、代码和自然语言推理任务。Ollama 是一个强大的工具,可以帮助用户在本地轻松部署和管理大型语言模型。

本文将详细介绍如何通过 Ollama 和 Open WebUI 在本地环境中部署 DeepSeek-R1 模型,并提供对 Ollama 和 DeepSeek-R1 的简要介绍,帮助用户快速上手

1. Ollama 简介

Ollama 是一个开源的本地化大模型部署工具,旨在简化大型语言模型(LLM)的安装、运行和管理。它支持多种模型架构,并提供与 OpenAI 兼容的 API 接口,适合开发者和企业快速搭建私有化 AI 服务。

Github:https://github.com/ollama/ollama

![图片[1]-DeepSeek-R1 本地部署指南:Ollama 助你轻松实现,支持2G显卡-www.znnu.com](https://pic1.zhimg.com/v2-784819e91ae6c68c54c4828c29ccb03a_1440w.jpg)

Ollama 的主要特点包括:

- 轻量化部署:支持在本地设备上运行模型,无需依赖云端服务。

- 多模型支持:兼容多种开源模型,如 LLaMA、DeepSeek 等。

- 高效管理:提供命令行工具,方便用户下载、加载和切换模型。

- 跨平台支持:支持 Windows、macOS 和 Linux 系统。

2. DeepSeek-R1 简介

DeepSeek-R1 是由深度求索(DeepSeek)公司开发的高性能 AI 推理模型,专注于数学、代码和自然语言推理任务。其核心优势包括:

- 强化学习驱动:通过强化学习技术显著提升推理能力,仅需少量标注数据即可高效训练。

- 长链推理(CoT):支持多步骤逻辑推理,能够逐步分解复杂问题并解决。

- 模型蒸馏:支持将推理能力迁移到更小型的模型中,适合资源有限的场景。

- 开源生态:遵循 MIT 开源协议,允许用户自由使用、修改和商用。

DeepSeek-R1 在多个基准测试中表现优异,性能对标 OpenAI 的 o1 正式版,同时具有更高的性价比。

![图片[2]-DeepSeek-R1 本地部署指南:Ollama 助你轻松实现,支持2G显卡-www.znnu.com](https://pica.zhimg.com/v2-b6240a5d96efd560e73b898b523c1eee_1440w.jpg)

3. 使用 Ollama 部署 DeepSeek-R1 的步骤

3.1 安装 Ollama

下载 Ollama

-

- 访问 Ollama 官网,根据操作系统(Windows、macOS 或 Linux)下载安装包。

- 对于 Windows 用户,下载

OllamaSetup.exe并双击安装。

![图片[3]-DeepSeek-R1 本地部署指南:Ollama 助你轻松实现,支持2G显卡-www.znnu.com](https://pic3.zhimg.com/v2-08a530075d0899f93ca2d4b7dad45134_1440w.jpg)

验证安装

-

- 安装完成后,打开命令行工具,输入以下命令验证是否安装成功:

ollama –version - 如果显示版本号,说明安装成功。

- 安装完成后,打开命令行工具,输入以下命令验证是否安装成功:

![图片[4]-DeepSeek-R1 本地部署指南:Ollama 助你轻松实现,支持2G显卡-www.znnu.com](https://pic3.zhimg.com/v2-8d77b9b4d795d94457db8164e216b732_1440w.jpg)

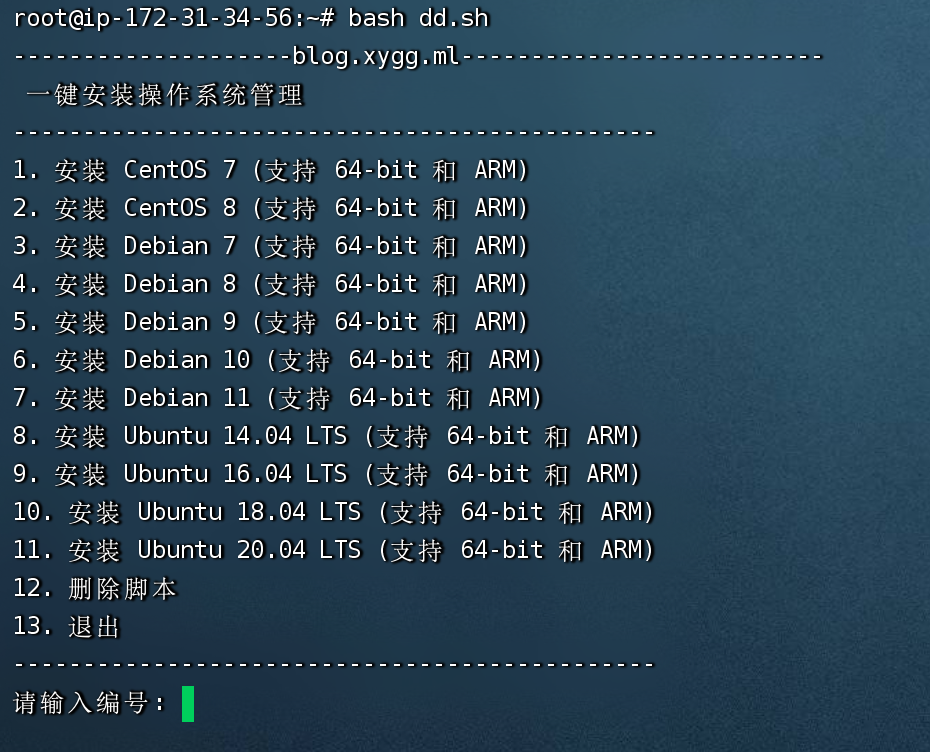

3.2 下载 DeepSeek-R1 模型

Ollama已经在第一时间支持DeepSeek-R1, 模型地址:deepseek-r1 。根据自己的显存选择对应的模型,2G显卡只能选1.5b的。

![图片[5]-DeepSeek-R1 本地部署指南:Ollama 助你轻松实现,支持2G显卡-www.znnu.com](https://pica.zhimg.com/v2-117e6ffd7ecb6df6348aa86a7825df3a_1440w.jpg)

下载模型

-

- 使用以下命令下载 DeepSeek-R1 模型:

ollama run deepseek-r1:1.5b - 该命令会自动下载并加载模型,下载时间取决于网络速度和模型大小。

- 使用以下命令下载 DeepSeek-R1 模型:

查看模型信息

-

- 下载完成后,可以使用以下命令查看模型信息:

ollama list - 该命令会列出本地已下载的模型及其状态。这是我笔记本上的本地模型。

- 下载完成后,可以使用以下命令查看模型信息:

![图片[6]-DeepSeek-R1 本地部署指南:Ollama 助你轻松实现,支持2G显卡-www.znnu.com](https://picx.zhimg.com/v2-d92ad37f7db0536c7300d153951ff329_1440w.jpg)

3.3 运行 DeepSeek-R1

启动模型

-

- 使用以下命令启动 DeepSeek-R1 模型:

ollama run deepseek-r1:1.5b - 启动后,模型会进入交互模式,用户可以直接输入问题并获取回答。

- 使用以下命令启动 DeepSeek-R1 模型:

测试功能

-

- 在交互模式下,可以测试 DeepSeek-R1 的多种功能,例如:

- 智能客服:输入客户常见问题,如“如何安装软件?”。

- 内容创作:输入“为一款智能手表撰写广告文案”。

- 编程辅助:输入“用 Python 实现快速排序”。

- 教育辅助:输入“解释牛顿第二定律”。

- 在交互模式下,可以测试 DeepSeek-R1 的多种功能,例如:

这是效果:

![图片[7]-DeepSeek-R1 本地部署指南:Ollama 助你轻松实现,支持2G显卡-www.znnu.com](https://picx.zhimg.com/v2-8033d9079dc78493314c57ce70027c83_1440w.jpg)

3.4 使用 Open WebUI 增强交互体验

只要是支持Ollama的webUI都可以,如Dify,AnythingLLM都可以。我这里用比较简单,而且也是与Ollama结合比较紧密的open-webui为例:

GitHub地址:https://github.com/open-webui/open-webui

如果有Python环境如Anaconda直接Pip安装即可

安装

pip install open-webui

启动服务

open-webui serve

启动后,在浏览器中访问 http://localhost:8080/ 即可进入 Open WebUI 界面。

选择模型并测试

在 Open WebUI 界面中,选择已下载的 DeepSeek-R1 模型,即可开始对话测试。

![图片[8]-DeepSeek-R1 本地部署指南:Ollama 助你轻松实现,支持2G显卡-www.znnu.com](https://pica.zhimg.com/v2-aa7b7d7e9751aa556be1e7d868930ad8_1440w.jpg)

效果非常不错。

4. 注意事项及资料

- 硬件要求:DeepSeek-R1 对硬件有一定要求,建议使用支持 GPU 的设备以获得更好的性能。

- 网络配置:如果下载速度较慢,可以使用国内镜像加速。

- 本地化支持:Open WebUI 支持中文界面,可以在设置中调整语言。

暂无评论内容